Por que chatbots não conseguem evitar casos de suicídio em jovens?

Casos recentes, como o do jovem Adam Raine, de 16 anos, que conversava com um chatbot antes de se suicidar, levantaram um alerta sobre os riscos do uso dessas tecnologias como forma de “terapia”.

Apesar das travas de segurança, chatbots como ChatGPT e Gemini funcionam com base em padrões estatísticos de linguagem e podem falhar em reconhecer sinais de risco, especialmente em diálogos longos. Essa limitação evidencia que, por mais avançados que sejam, esses sistemas não possuem a sensibilidade humana necessária para lidar com situações complexas como a ideação suicida.

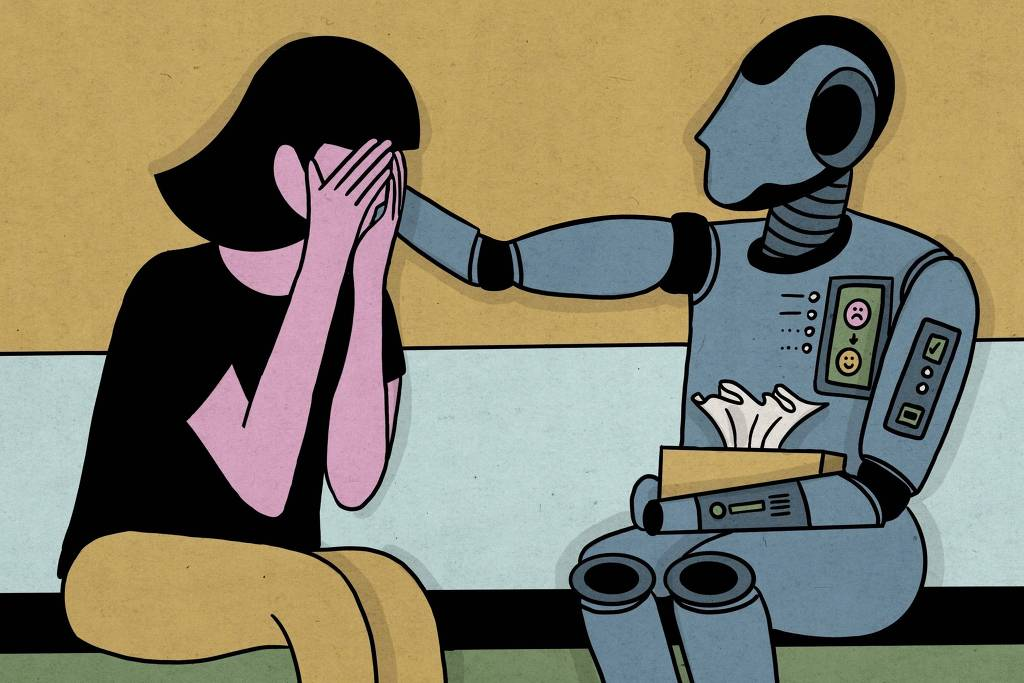

A popularidade desses recursos reflete a busca por um espaço seguro para desabafar, mas reforça também a importância do acompanhamento humano, que continua sendo insubstituível no cuidado com a saúde mental.

Para tornar essas interações mais seguras, especialistas sugerem protocolos que permitam acionar autoridades ou serviços de emergência quando sinais de risco forem detectados. Ainda assim, o consenso é claro: a inteligência artificial não substitui o cuidado humano.